Dieser Artikel wurde von Philipp Luthiger von AFO-Marketing geschrieben. Wir von copebit haben an diesem Artikel mitgearbeitet und posten deshalb auch auf unserem Blog hier. Das Original des Blogs liegt hier. Herzlichen Dank an AFO-Marketing für die Einladung zur Mitarbeit.

Public Clouds wie Amazon Web Services (AWS), Microsoft Azure und Google Clouds wegen ihrer Flexibilität und dem Wegfall hoher Investitionskosten sowohl für Grossfirmen, aber auch für KMUs gewaltige Vorteile bringen, wird heute kaum mehr bestritten.

Haben Sie eine Frage zu Cloud Security?

Kontaktieren Sie uns und wir helfen Ihnen gerne weiter!

Dennoch stossen Public Clouds bei vielen nach wie vor auf grosse Skepsis. «Das kann doch nicht sicher sein!», «Ich stelle unsere Daten doch sicher nicht freiwillig Amazon/Microsoft/Google zur Verfügung!» oder «Unsere Daten dürfen nur in der Schweiz gehostet werden!» sind dabei nur einige von häufig gehörten Reaktionen.

Doch wie sicher sind Public Clouds tatsächlich? Ist es wirklich gefährlicher und fahrlässiger, die Daten in einer Public Cloud zu speichern, statt im eigenen Rechenzentrum? Und welche Massnahmen können getroffen werden, um die Daten auch in einer Public Cloud zuverlässig vor unberechtigtem Zugriff und böswilligen Attacken, aber auch vor versehentlichem Datenverlust zu schützen?

Diesen Fragen versucht dieser Blog-Artikel nachzugehen. Und da es bezüglich Sicherheit keine absolut sichere und abschliessende Antwort geben kann, wurde dieser Artikel in Zusammenarbeit mit Marco Kuendig von copebit, unserem Partner im Bereich Cloud-Infrastruktur, verfasst. So können wir die einzelnen Aspekte aus verschiedenen Blickwinkeln beleuchten.

Inhaltsverzeichnis:

1 Public Cloud vs. Private Cloud

2 Sicherheitsrisiko Infrastruktur

2.1 Einschätzung Philipp Luthiger, AFO

2.2 Einschätzung Marco Kuendig, copebit

3 Sicherheitsrisiko Datenschutz und Compliance

3.1 Einschätzung Philipp Luthiger, AFO

3.2 Einschätzung Marco Kuendig, copebit

4 Sicherheitsrisiko Cyberkriminalität

4.1 Einschätzung Philipp Luthiger, AFO

4.2 Einschätzung Marco Kuendig, copebit

5 Sicherheitsrisiko Mensch

5.1 Einschätzung Philipp Luthiger, AFO

5.2 Einschätzung Marco Kuendig, copebit

6 Fazit

7 Haben Sie eine Frage zu Cloud Security?

8 Haben Sie eine Frage zu Cloud Security?

Public Cloud vs. Private Cloud

Gemäss Definition des National Institute of Standards and Technology (NIST) handelt es sich bei Cloud-Computing um den Ansatz,

- IT-Infrastrukturen über ein Rechnernetz zur Verfügung zu stellen, ohne dass diese auf dem lokalen Rechner installiert sein müssen.

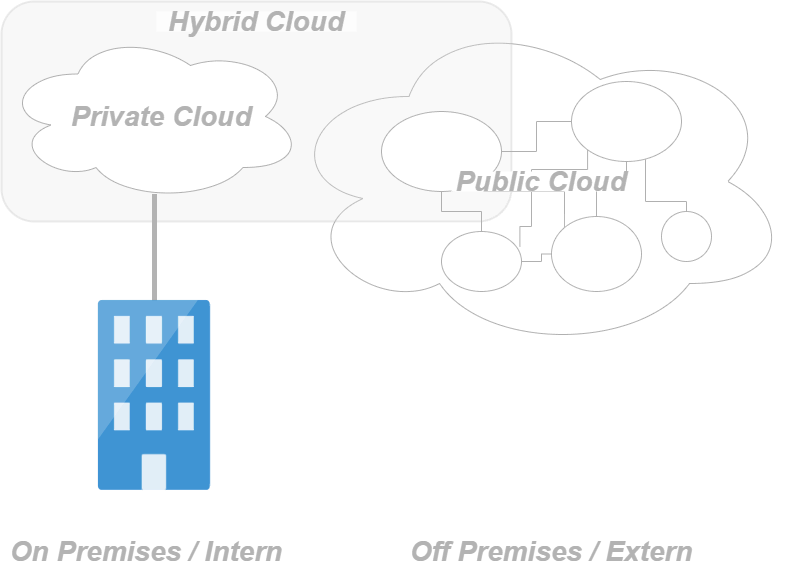

Interessant an dieser Definition ist, dass es somit grundsätzlich kaum noch eine IT-Infrastruktur mehr gibt, die nicht in der Cloud läuft, da kaum eine IT-Infrastruktur mehr denkbar ist, die nicht über ein (grösseres oder kleineres) Rechnernetz zur Verfügung gestellt werden kann. Die Unterscheidung zwischen Cloud und Nicht-Cloud wird somit hinfällig, und das NIST unterscheidet denn auch vielmehr zwischen Public Cloud und Private Cloud (sowie der Hybrid Cloud als Zwischenform).

Im Unterschied zur Private Cloud, die ausschliesslich für eine Organisation oder ein Unternehmen betrieben wird, bietet die Public Cloud dabei Zugang zu abstrahierten IT-Infrastrukturen für die breite Öffentlichkeit direkt über das Internet. Die IT-Infrastruktur wird dabei vom Kunden nicht gekauft, sondern nur vermietet, wobei die Bezahlung entsprechend der tatsächlichen Nutzung (pay-as-you-go) erfolgt, ohne Kapital in Rechner- und Datenzentrumsinfrastruktur investieren zu müssen. Und gerade diese Vorstellung, dass die Public Cloud grundsätzlich für alle frei über das Internet zugänglich ist und keine eigene Infrastruktur benötigt wird, stösst bei vielen nach wie vor auf grosse Skepsis. Doch diese Vorstellung ist falsch: So wenig eine Private Cloud die eigenen Daten vor unberechtigtem Zugriff vollständig schützen kann, so wenig liegen diese in einer Public Cloud einfach ungeschützt bereit. Letztlich sind die Unterschiede zwischen einer Private Cloud und einer Public Cloud bezüglich Sicherheit denn auch viel kleiner als gemeinhin angenommen, denn:

- auch in der Public Cloud lassen sich die Daten mit Hilfe von virtuellen privaten Netzwerken (VPC) und Firewalls komplett von anderen Netzwerken abschotten;

- auch in der Public Cloud lässt sich mit Hilfe von Subnets, Routing-Tables und Security Groups der Datenfluss detailliert kontrollieren;

- auch in der Public Cloud lässt sich mit Hilfe von User, User-Gruppen, Rollen und Access Policies detailliert steuern, welche User oder Applikationen auf welche Daten und Services zugreifen dürfen.

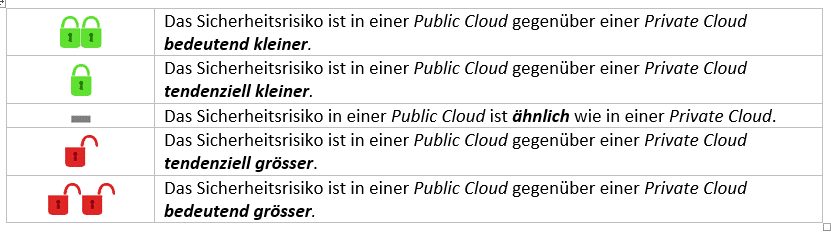

Aber selbstverständlich gibt es auch wesentliche Unterschiede bzw. besondere Herausforderungen bezüglich Sicherheit, die in einer Public Cloud speziell berücksichtigt werden müssen. Im Folgenden sollen vier Bereiche näher beleuchtet und insbesondere geprüft werden, inwieweit Sicherheitsbedenken einer Public Cloud gegenüber einer Private Cloud tatsächlich berechtigt sind, bzw. was in einer Public Cloud speziell zu berücksichtigen ist. Jeder Bereich endet dabei mit einer individuellen und sehr persönlichen Einschätzung des Sicherheitsrisikos einer Public Cloud gegenüber einer Private Cloud:

Sicherheitsrisiko Infrastruktur

Jede Infrastruktur birgt diverse Risiken für den Verlust der eigenen Daten mit sich. Ganze Datenzentren können von Naturkatastrophen wie Feuer, Überflutungen und Erdbeben, aber auch durch Terrorangriffe und Kriege zerstört werden, die Stromzufuhr kann abbrechen, aber auch einzelne Komponente wie Netzwerke und Laufwerke können fehlerhaft sein und so ganze Datenbestände unbrauchbar machen. Wie gross ist somit die Gefahr von solchen Ereignissen für die Public Cloud, bzw. wie werden die Daten vor diesen Gefahren geschützt?

Einschätzung Philipp Luthiger, AFO

Einstufung:

Kein einzelnes Datencenter und noch viel weniger einzelne physische Hardware-Komponenten wie Server, Netzwerkleitungen, Speichermedien etc. können absolute Sicherheit vor Ausfall und Defekten garantieren. Deshalb basiert jedes infrastrukturelle Sicherheitskonzept primär auf Redundanz: nur wenn eine Infrastruktur und die Daten an möglichst vielen und voneinander unabhängigen Orten gespiegelt werden, kann die Gefahr von systemkritischen Unterbrüchen oder Datenverlust minimiert werden. Und hier liegt zweifelsohne eine der ganz grossen Stärken und Vorteile einer Public Cloud, wie sie z.B. von Google, Microsoft und Amazon angeboten werden: dank ihren enormen finanziellen Ressourcen und ihrer globalen Vernetzung ist es ihnen möglich, ihre Services über ein weltweites und ständig wachsendes Netz von einzelnen Rechenzentren (sog. Availability Zones) bereit zu stellen, aufgeteilt in Regionen, wobei jede Region immer über mehrere Availability Zones verfügt, die sich über speziell gute und performante Verbindungen untereinander und folglich sehr geringen Latenzzeiten auszeichnen.

Jedes dieser Rechenzentren ist dabei mit unabhängiger Stromversorgung, Kühlung und Vernetzung ausgestattet und gewährleistet dadurch eine optimale Ausfallsicherheit. Zone-redundante Services replizieren zudem die Anwendungen und Daten kontinuierlich über mehrere Availability Zones, um vor Single-Point-of-Failure-Ausfällen zu schützen. Fällt eines der Rechenzentren oder einzelne Komponenten aus, können somit sehr einfach und schnell dieselben Services einfach über ein anderes Rechenzentrum bezogen werden.

Dies garantiert eine Ausfallsicherheit, die weit über die Möglichkeiten von kleineren oder gar nur lokal tätigen Anbieter hinausgeht. So unsympathisch global tätige Mega-Konzerne wie Microsoft, Google und Amazon in vielerlei Hinsicht auch wirken mögen, so verfügen doch nur sie über die nötigen finanziellen Ressourcen, um eine solche globale und dezentrale Infrastruktur bereitstellen zu können.

Anzahl Regionen und Availability Zones pro Anbieter (Stand: November 2020):

Einschätzung Marco Kuendig, copebit

Einstufung:

Ein Hyperscaler baut seine Infrastruktur von Grund auf so auf, dass diese hochverfügbar, hoch verteilt und hoch skalierbar ist. Hyperscaler sind selber riesige Unternehmen und bauen Infrastrukturen für andere globale Konzerne. So hat z.B. AWS die globale Streaming-Infrastruktur für Netflix gebaut, die über enorme Skalierung und Verfügbarkeitsanforderungen verfügt. Sie muss global gesehen massive Angriffe auf die Datensicherheit wie auch die Verfügbarkeit abdecken. Und jeder Kunde eines Hyperscalers hat nun die Möglichkeit, die gleichen Prinzipien, Methoden und Architekturen wie die der ganz grossen Unternehmen zu verwenden. Das macht die Infrastruktur sehr viel höher verfügbar. Der Schutz der Infrastruktur ist auch um einige Faktoren höher, da sich viele, sehr hoch gebildete, wie auch auf Security sensibilisierte Personen jahrelang damit beschäftigen, hochsichere Infrastrukturen und Services zu entwickeln.

Zudem sind die Services unter konstantem Angriff von Bots, Hackern und anderen Akteuren, und sollte tatsächlich mal etwas mit der Security nicht in Ordnung sein, wird dies schnell entdeckt und dann global automatisiert gelöst. Des Weiteren werden immer mehr Teile der Infrastruktur mit künstlicher Intelligenz automatisch überwacht. Werden also Anomalien entdeckt (Zugriffe von unüblichen Lokationen, grosse Änderungen, Datenabfluss), so werden diese automatisch detektiert und sofort an die zuständigen DevOps-Personen übergeben.

Für besonders wichtige Daten bietet ein Hyperscaler auch immer die Möglichkeit, diese mehrfach redundant und sogar über mehrere Regionen verteilt zu speichern. Dies erlaubt Backup und Disaster Recovery-Möglichkeiten, die selbst grösste Unternehmen in ihren eigenen Rechenzentren nicht erreichen können.

Sicherheitsrisiko Datenschutz und Compliance

Ein sehr häufig gehörtes Argument gegen eine Public Cloud ist die fehlende Kontrollmöglichkeit von Datenschutzmassnahmen und Bedenken bezüglich Persönlichkeitsschutz, häufig verbunden mit einem vagen Misstrauen gegenüber multinationalen Grosskonzernen wie Google, Amazon und Microsoft. Doch wie berechtigt sind solche Bedenken tatsächlich? Ist es tatsächlich sicherer, meine Daten ausschliesslich bei einem lokalen Anbieter hier in der Schweiz zu hosten? Und verliere ich in der Public Cloud tatsächlich jede Kontrollmöglichkeit darüber, wo meine Daten gespeichert werden?

Einschätzung Philipp Luthiger, AFO

Einstufung:

Alle drei führenden Public Cloud-Anbieter (Google, Amazon und Microsoft) gelten gemeinhin als Datenkraken, d.h. als multinationale Grosskonzerne, die personenbezogene Informationen im grossen Stil auswerten oder sie an Dritte weitergeben, auch unter Verletzung von Datenschutzbestimmungen und Persönlichkeitsrechten. Entsprechend gross ist das Misstrauen, dass dies auch mit den in ihren Public Clouds gespeicherten Daten geschieht, d.h., dass der eigentliche Zweck der Public Cloud nur darin besteht, relativ einfach in den Besitz von Unmengen an Daten zu gelangen.

Dass ein wesentlicher Teil ihres Geschäftsmodells darin besteht, aus Unmengen von Daten Informationen zu generieren und diese Informationen für viel Geld an Dritte zu verkaufen, kann sicher nicht bestritten werden. Andererseits kann bezweifelt werden, ob für sie die Public Clouds dafür auch tatsächlich geeignet sind. Folgende Gründe sprechen dagegen:

- Alle diese drei grossen Anbieter haben bereits andere und viel einfachere Wege verfügbar, um sehr einfach und schnell an personengebundene Daten zu kommen.

- Auch mit ihren Public Clouds verdienen die Anbieter enorm viel Geld. Dies funktioniert jedoch nur, wenn sie das Vertrauen der Nutzer haben. Die Anbieter investieren dann auch enorm viel Geld in den Schutz ihrer Infrastruktur, um dieses Vertrauen zu gewinnen und beibehalten zu können. So sind bei AWS sämtliche Rechenzentren über eine eigene, speziell entwickelte Netzwerkinfrastruktur miteinander verbunden, der Datenverkehr bleibt somit komplett von jeglichem anderen Datenverkehr abgeschottet. Es ist deshalb kaum vorstellbar, dass sie dieses Vertrauen leichtfertig aufs Spiel setzen wollen, zumal sie – es sei noch einmal erwähnt – bereits Wege haben, um viel einfacher an personengebundene Daten zu gelangen.

Es wird von allen Anbietern auch garantiert, dass Daten ohne aktiven Eingriff durch den Nutzer immer innerhalb einer Region bleiben, in der sie abgelegt oder generiert wurden. Daten, die z.B. in der AWS-Region ‘eu-central-1’ (Frankfurt) gespeichert oder von einem Dienst in dieser Region generiert wurden, bleiben somit in dieser Region, es sei denn, sie werden vom Nutzer aktiv in eine andere Region transferiert. Sie unterliegen dabei auch immer den Datenschutzverordnungen der entsprechenden Region, im Falle sämtlicher EU-Regionen somit der Datenschutzrichtlinie der EU (DSGVO), im Falle der CH-Regionen (aktuell erst für Microsoft Azure und Google Cloud verfügbar, ab nächstem Jahr auch für AWS geplant) dem Schweizer Datenschutz, wobei es letztlich immer in der Verantwortung des Cloud-Nutzers liegt, dass diese Datenschutzbestimmungen auch tatsächlich korrekt eingehalten werden.

Grundsätzlich ist das Sicherheitsrisiko für Datenschutz und Compliance in einer Public Cloud sicher nicht grösser als in einer Private Cloud, tendenziell dürfte der Schutz der Daten dank der bereitgestellten Tools in einigen Bereich gar einfacher zu gewährleisten sein als On-Premise.

Einschätzung Marco Kuendig, copebit

Einstufung:

![]()

Der Datenschutz bei den grossen Hyperscalern ist sehr stark durch technische Vorrichtungen geschützt. Verschlüsselungen, in Zukunft Confidential Computing und sehr strikte Zugangsregelung sichern den Zugriff auf die gespeicherten Daten.

Auch weil diese Firmen eh schon unter Generalverdacht stehen, ist der Schutz aufgrund ihrer anderen Business-Modelle (Search, E-Commerce, Analytics) vertraglich stark abgesichert. Die Schwierigkeit liegt eher darin, dass die drei führenden Konzerne ihre Mutterhäuser in den USA haben und dass die USA seit der NSA-Affäre, die von Edward Snowden aufgedeckt wurde, mit sehr schlechter Reputation in Sachen Datenschutz dastehen. Auch die von der US-Regierung verabschiedeten Gesetze rund um den Cloud-Act helfen nicht, die rechtliche Einschätzung leichter zu machen. Da spielt auch eine gewichtige Portion “schlechtes Bauchgefühl” mit dazu.

Viele Menschen teilen privat viele ihrer Gedanken mit Google, texten sehr freizügig mit WhatsApp, laden private Bilder auf iPhotos hoch und machen sich keinerlei Gedanken beim Akzeptieren von “Terms and Conditions” oder beim Installieren von Gratis-Apps. Die meisten dieser Apps stammen von US-Konzernen, oft mit sehr laxen Bestimmungen beim Schutz von privaten User-Daten.

Beim Gebrauch von Cloud-Dienstleistungen im geschäftlichen Umfeld werden jedoch höchste Zertifizierungen eingefordert. Da die Hyperscaler schon seit bald 10 Jahren in diesem Umfeld tätig sind, liegen natürlich global enorm hohe Sicherheitsstandards-Zertifikate vor. Von PCI-DSS, ISO 27001 und vielen anderen lokalen Sicherheitsanforderungen sind die Zertifikate, ausgestellt auf die Cloud-Plattformen, bereits verfügbar, und da diese nun einmal für die Plattform eingeholt werden müssen, können alle Kunden auf diese Zertifikate zugreifen und sie entsprechend verwenden.

Und zu guter Letzt ist da natürlich das Reputationsschadens-Risiko der Provider. Die Hyperscaler haben auch gegen Ende des Jahres 2020 nur einen sehr kleinen Anteil am gesamthaften IT-Markt. Man schätzt, dass erst etwa 3-5% der weltweiten IT-Ausgaben in die Umsatzbücher der Hyperscaler fliessen.

Der Cloud-Markt ist noch sehr jung und wird von sehr grossen und finanzkräftigen Playern beherrscht. Es bedarf etlicher Milliarden an Investition, um in diesem Markt überhaupt Fuss fassen zu können. Der Autor ist überzeugt, dass der Marktanteil eines Hyperscalers, der beim Missbrauch von Kundendaten erwischt wird, signifikant einbrechen würde. Ein solches Business- und Reputationsrisiko würde wohl keiner der Player eingehen wollen.

Sicherheitsrisiko Cyberkriminalität

Cyberkriminalität, d.h. böswillige Angriffe auf die eigene IT-Infrastruktur, ist seit den ersten Stunden des Internets und der zunehmenden Vernetzung der einzelnen Computer und IT-Netzlandschaften eine der grössten Bedrohungen und hat mit dem Aufkommen der Public Clouds zweifelsohne an weiterer Dringlichkeit gewonnen. Sind meine Daten in einer Public Cloud tatsächlich weniger gut schützt als in einer Private Cloud?

Einschätzung Philipp Luthiger, AFO

Einstufung:

![]()

Ein viel gehörtes und gelesenes Argument gegen die Public Cloud ist, dass diese stärker Cyber-Angriffen ausgesetzt sind als die in den eigenen Rechenzentren gespeicherten Daten. Tatsächlich enthüllt eine neue Sophos-Studie vom Juli 2020 («The State of Cloud Security 2020»), dass fast drei Viertel der Unternehmen, die Daten oder Workloads in der Public Cloud hosten, im vergangenen Jahr einen Sicherheitsvorfall erlebt haben: 70% der Organisationen berichten, dass sie von Malware, Lösegeldforderungen, Datendiebstahl, Versuchen der Konten-Kompromittierung oder Cryptojacking betroffen waren.

Zusätzlich hat Sophos im Rahmen einer 30-tägigen Studie untersucht, wie sehr Public-Cloud-Server Hackerangriffen ausgesetzt sind. Hierfür wurden in den weltweit beliebtesten Amazon Web Services-Datenzentren sog. Honeypots eingerichtet. Diese simulierten den auf den allermeisten Linux-Servern erreichbaren Secure Shell (SSH)-Dienst, um SSH-Anmeldeversuche zu messen. Das Resultat: Bereits in den ersten 30 Tagen der Studie wurden insgesamt mehr als fünf Millionen Angriffsversuche auf das globale Honeypot-Netz verzeichnet, darunter knapp 440.000 Angriffsversuche allein in Frankfurt.

Grundsätzlich kann somit festgehalten werden: die Befürchtung, dass Public Clouds vermehrt Cyber-Angriffen ausgesetzt sind, ist sicher nicht unbegründet. Ein Grossteil dieser Vorfälle dürfte jedoch eher auf Fehlkonfigurationen, unsachgemässe Nutzung und fehlendes Sicherheitsbewusstsein zurückzuführen sein als einer tatsächlich grösseren Attraktivität der Public Cloud für Cyberattacken (vgl. «Sicherheitsrisiko Mensch»). So hält der Sophos-Report auch fest, dass die Sicherheitssorgen zwar begründbar sind, dies jedoch nicht, weil die von den Plattformanbietern bereitgestellten Infrastrukturen an sich verwundbar sind, sondern weil die Konfiguration von Public-Cloud-Infrastrukturen und -Diensten besondere Sorgfalt und Expertise auf Seiten der nutzenden Unternehmen erfordern.

Tatsächlich lässt sich auch in einer Public Cloud die eigene Umgebung mit exakt denselben Techniken absichern, wie sie auch für das lokale Netzwerk zur Verfügung stehen (wie z.B. Network Access Control Lists (NACS), Security Groups, Routing Tables, granulares User und Access Management etc.). Zudem wird von den Cloud-Anbietern ein ganzes Set von weiteren Security-Tools zur Verfügung gestellt, um den Datenfluss innerhalb des Netzwerkes beobachten und allfällige Attacken frühzeitig erkennen zu können (wie z.B. CloudWatch, AWS Shield, GuardDuty von Amazon, Azure Monitor, Security Center, Azure DDoS Protection von Microsoft oder Chronicle von Google).

Somit lässt sich sicher festhalten, dass Daten und Netzwerke in einer Public Cloud grundsätzlich nicht schlechter geschützt sind als in der Private Cloud, vorausgesetzt jedoch, dass die empfohlenen und verfügbaren Sicherheitsmassnahmen auch tatsächlich korrekt und umfassend implementiert werden.

Einschätzung Marco Kuendig, copebit

Einstufung:

![]()

Eine neutrale Einstufung wird hier erteilt, da sich die Vor- und Nachteile aufheben. Vorteile sind klar, wie im Abschnitt Infrastruktur erwähnt: die Möglichkeiten zur Verschlüsselung bei Speicherung, Transport und Ausführung der Daten sowie auch die sensationellen Möglichkeiten, wichtige Daten sehr einfach zu backupen und über mehrere Datenzentren, Availability Zones und auch Regionen zu verteilen.

Auf der anderen Seite ist es durch die hohe Automatisierung, die hohe Konnektivität und die Einfachheit der Cloud-Provider auch sehr einfach möglich, dass Verbindungen ins Internet ermöglicht werden, die in einer privaten Infrastruktur vielleicht nur durch eine weitere Person geöffnet werden könnten. Zum Beispiel sehen wir als Cloud Consulting Partner immer wieder, dass Kunden bei Troubleshooting-Aktionen sehr grosszügig Rollen oder Firewall-Rules ändern. Da mit den korrekten Rechten auf einer Cloud Platform jegliche Einstellungen selbst ausgeführt werden können, ist natürlich die Gefahr einer Misskonfiguration höher. Bei einer privaten Infrastruktur hat der Server-Verantwortliche vielleicht das Passwort der Firewalls gar nicht und kann eine solche Öffnung gar nicht so leicht durchführen.

Die Hyperscaler sind sich der Chancen und Risiken dieser hohen Automatisierung und Flexibilität bewusst und versuchen, die Einfachheit des Handlings mit den Sicherheits-Grundanforderungen zu balancieren. Viele Default-Einstellungen bei den grossen Providern sind “vernünftig” und stellen eine gute Basis für die Applikationssicherheit bereit. Das riesige Angebot an Security-Features erlaubt zudem, auch mit überschaubaren Zusatzaufwand hochsichere Infrastrukturen für die Applikationen zu erstellen.

Durch das Verwenden der zur Verfügung stehenden Features kann auch leicht die Applikationssicherheit erhöht werden. Ein Beispiel dazu ist das Microzoning der Applikationselemente wie VMs, Containers und DBs. Die Provider bieten durch das Software Defined-Netzwerk Filtering-Möglichkeiten, die es erlauben, die Netzwerkzugriffe sehr granular zu steuern. Das sorgfältige Design und der Einsatz solcher Features reduzieren die möglichen Angriffsvektoren deutlich.

Falls tatsächlich ein Security-Incident erfolgt, können solche Breaches durch den Einsatz von künstlicher Intelligenz schnell detektiert und mitigiert werden. Ein Beispiel für künstliche Intelligenz im Security-Umfeld ist z.B. die Überwachung der S3 Buckets bei AWS. Falls Macie, das KI-basierte Monitoring-Tool, z.B. Daten in S3 entdeckt, die vorher nicht visibel waren, oder geheime Personendaten wie Kreditkartennummern im grossen Stil entdeckt, schlägt es Alarm, und durch eine Automatisierung könnte ein Prozess den Zugang zu diesen Daten sofort unterbinden.

Sicherheitsrisiko Mensch

Jedes Sicherheitssystem ist nur so stark, wie sich die beteiligten Personen auch an die empfohlenen Massnahmen halten und die bereitgestellten Instrumente (korrekt) nutzen können und wollen. Gerade bei dermassen komplexen Systemen, die über eine Public Cloud relativ einfach bereitgestellt werden können, ist somit die Gefahr sicher nicht zu unterschätzen, dass es zu (unbeabsichtigten) Fehlmanipulationen kommen kann und kritische Sicherheitslücken unentdeckt bleiben. Ist diese Gefahr bei Public Clouds tatsächlich grösser als in einer Private Cloud, bzw. welche Massnahmen und Möglichkeiten gibt es, um diese auch in einer Public Cloud minim zu halten?

Einschätzung Philipp Luthiger, AFO

Einstufung:

Die Public Cloud-Lösungen von Amazon, Microsoft und Google basieren alle auf einem Shared Responsibility-Modell: Während die Anbieter für die Sicherheit der Cloud an sich zuständig sind, ist der Cloud-Nutzer für die Sicherheit seiner Daten und Workloads innerhalb der Cloud verantwortlich, wobei ihm vom Anbieter eine Reihe von Tools zur Verfügung gestellt wird, um diesen Schutz möglichst optimal gewährleisten und überwachen zu können.

Eine Studie von McAfee von Anfang 2020 («Unternehmen als Supernova: Risiken durch die Verbreitung von Daten in der Cloud») stellt fest, dass die Kunden diesem Prinzip zwar zugestimmt, es jedoch häufig nicht verstanden haben. So ist gemäss dieser Studie jeder fünfte Manager für Netzwerksicherheit der Meinung, dass die Cloud-Anbieter für die Absicherung der Unternehmensdaten verantwortlich sind, tatsächlich fällt dies jedoch in seinen Verantwortlichkeitsbereich. Die Cloud-Anbieter implementieren z.B. selber keine Kontrollen, welche Daten in der Cloud gespeichert sind, wer darauf zugreifen kann und wohin sie übertragen werden, dies muss grundsätzlich vom Cloud-Nutzer selber überwacht und kontrolliert werden. Im Rahmen dieser Umfrage sagten zudem 30% der Unternehmen, dass ihnen Fachkräfte mit den erforderlichen Kenntnissen zur Absicherung von Cloud-Anwendungen fehlen, was einer Zunahme von 33% gegenüber einer analogen Umfrage aus dem Vorjahr entspricht.

Dies dürfte denn auch die eigentliche Problematik von Public Cloud-Lösungen sein: sämtliche Lösungen haben sich in den letzten Jahren enorm weiterentwickelt, und monatlich kommen eine Vielzahl von neuen Services oder Features hinzu, die grundsätzlich zwar häufig sehr einfach zu nutzen und deshalb auch sehr schnell implementiert werden können, doch diese Geschwindigkeit und Häufigkeit von Public Cloud-Bereitstellungen stellt eine ernsthafte Herausforderung dar. So belegt eine Sicherheitsstudie von Orca aus diesem Jahr («The Orca Security 2020 State of Public Cloud Security Report»), dass Unternehmen aus verschiedenen Branchen mit Amazon, Microsoft und Google immer schneller immer mehr Assets in der öffentlichen Cloud bereitstellen und damit zahlreiche Wege zu deren Missbrauch offen lassen. Das Problem dabei ist, dass eine an sich durchgängige Cloud-Sicherheit durch ihre schwächsten Glieder – nicht gepflegter internetbezogener Workload, offengelegte Zugangsdaten, unverschlüsselte Daten – leicht durchbrochen werden kann. So ergab diese Studie, dass

- 44% der befragten Unternehmen mit dem Internet verbundene Workloads haben, die Unternehmensgeheimnisse und Zugangsdaten mit Klartext-Passwörter, API-Schlüssel und Hash-Passwörter enthalten;

- 24% über ein Cloud-Konto verfügen, welches keine Multi-Faktor-Authentifizierung für den Super-Administrator verwenden und 19% über Cloud-Assets, auf die über externe Zugangsdaten zugegriffen werden kann;

- 5% Cloud-Workloads besitzen, die entweder mit einem schwachen oder durchgesickerten Passwort zugänglich sind.

Grundsätzlich ist das Sicherheitsrisiko «Mensch» in einer Public Cloud jedoch nicht wesentlich grösser als in einer Private Cloud, sie akzentuiert sich jedoch durch die Geschwindigkeit und Häufigkeit, in der immer wieder neue Services und Features bereitgestellt werden. Deshalb ist es für jedes Unternehmen, welches die Public Cloud nutzen will, unerlässlich,

- dass sie sich ihrem Teil der Verantwortung voll bewusst ist;

- dass die getroffenen Sicherheitsmassnahmen auch tatsächlich 100% des Cloud-Assets abdecken, damit Angreifer sich nicht durch die schwächsten Glieder einschleichen können;

- dass die Nutzung von Public Cloud-Services schrittweise erfolgt, angefangen bei einfachen, gut überschaubaren Diensten, bevor eine ganze Infrastruktur in die Cloud migriert wird;

- dass ganz gezielt cloud-spezifisches Know-How aufgebaut und gepflegt wird;

- dass die bereitgestellten Tools zur Sicherung und Überwachung der eigenen Umgebung auch tatsächlich genutzt und korrekt implementiert werden.

Einschätzung Marco Kuendig, copebit

Einstufung:

Bei einer Cloud-Plattform wird alles über ein einzelnes API gesteuert. Das bringt massive Vorteile für die Usability, Auditierung, Automatisierung und Standardisierung mit sich. Im Gleichschritt birgt dies aber auch die grosse Gefahr, dass eine einzelne Aktion grossen Schaden anrichten kann. Wenn z.B. ein Administrator das Root- oder Admin-Passwort/Token versehentlich veröffentlicht (commit in Github, Hack oder Leak bei einer Demonstration), dann kann dieser Incident sehr grosse Auswirkungen haben wie Totalverlust der Daten oder massiv mit Malware verseuchte Server. Typische menschliche Fehler sind auch immer wieder bei falsch konfigurierten Scripts oder Automatisierungs-Routinen anzutreffen. Durch Best Practices oder Policies können solche Incidents minimiert werden, jedoch sehen wir immer wieder, dass Administratoren solche Empfehlungen nicht aktivieren oder befolgen.

Durch die Möglichkeiten der Cloud ist auch ein grosser Wandel im Gebrauch der Technologie zu sehen. Man kann sehr leicht experimentieren und mit wenig Aufwand sehr hohe Innovation erreichen. Oft wird jedoch vergessen, dass auch bei der Sicherung der Infrastruktur und der Applikation sehr detailiert Policies und Controls implementiert werden müssen. Ein Experiment wird ohne Audit oder Pentesting in die Produktion überführt und öffentlich zugänglich gemacht. Das kann dann schnell zu einem Security-Incident führen, bei dem Datenverluste, massive Kostenaufwände und ein Reputationsschaden eintreten können.

Es ist aber auch eine sehr hohe Innovationskraft der Hyperscaler zu sehen. Der tägliche Einsatz der agilen Methoden führt zu einer hohen Dynamik, die enorme Mehrwerte schafft, aber auch gleichzeitig erfordert, dass die eingesetzten unterliegenden Technologien einem konstanten Wandel unterzogen sind. Wer diesen Wandel missachtet, z.B. vergisst zu patchen oder die Änderungen an der Plattform nicht konstant nachimplementiert, kann erleben, dass seine Applikationen nicht mehr richtig funktionieren oder sogar Datenverluste (z.B. durch nicht erfolgte Backups) auftreten.

Zu guter Letzt: Viele Cloud-Technologien und Features sind anders zu bedienen als herkömmliche und bereits bekannte Tools. Das Wissen in Cloud-Technologien entwickelt sich in der breiten IT-Organisation nur langsam und die nötige Verhaltensänderung bei allen Mitarbeitenden zieht sich oft über Jahre hinweg. Erschwerend kommt hinzu, dass die meisten Unternehmen für eine Cloud-Migration mehrere Jahre benötigen und deshalb sowohl die vorherige wie auch die neue Plattform mit ihren jeweiligen Eigenheiten betreiben müssen.

Fazit

Gerade für ein Kleinunternehm wie AFO, das viele Projekte im Bereich Machine Learning durchführt und deshalb immer wieder für relativ kurze Zeit auf sehr leistungsfähige Server angewiesen ist, bieten die Public Clouds mit ihrem Pay-as-you-go-Preismodell enorme Vorteile. Gleichzeitig arbeiten wir oft mit hochsensiblen Daten, weshalb für uns der Schutz dieser Daten immer oberste Priorität hat. Es war für uns deshalb ein wichtiger und – und wie wir immer wieder merken – ein guter Entscheid, mit copebit einen ausgewiesenen Fachmann im Bereich Cloud-Sicherheit als Partner zu gewinnen.

Die Public Clouds stellen ganz spezifische Anforderungen an die Sicherheitsvorkehrung, sie bieten jedoch auch die entsprechenden Tools und Vorkehrungen, um diesen Herausforderung – mit dem entsprechenden Fachwissen im Hintergrund – gerecht zu werden.

Unsere Experten und Autoren für diesen Blogbeitrag:

Herzlichsten Dank an dieser Stelle an Herr Marco Kündig und der Firma copebit AG für die angenehme und gute Zusammenarbeit.

Philipp Luthiger

AFO Marketing AG –

Experte und Autor

Marco Kuendig

Firma copebit AG –

Experte und Gast-Coautor

Wenn Sie für Ihr Unternehmen eine passende Cloud Lösung suchen, oder Beratung für Ihre Cloud Infrastruktur & Aufbau benötigen, stehen wir Ihnen gerne beratend zur Seite.

Haben Sie eine Frage zu Cloud Security?

Kontaktieren Sie uns und wir helfen Ihnen gerne weiter!